Si vous avez l’habitude de passer sur Joptimisemonsite, vous savez que j’apprécie traiter des sujets liés au référencement naturel. Souvent, je vous livre des techniques assez simples à mettre en place pour corriger ou optimiser votre référencement.

Aujourd’hui, j’ai eu envie de traiter d’un sujet un peu plus technique et que trop peu d’e-commerçant font: l’analyse de logs. Et pourtant, cette analyse est très importante pour réussir à positionner dans les résultats de Google.

Pour traiter ce sujet, il faut dans un premier temps que je vous explique ce qu’est une analyse de logs et en quoi cela consiste. Puis, je vous expliquerai l’intérêt de réaliser une telle analyse et surtout comment cela peut améliorer le référencement naturel de votre site.

Si vous avez des questions à la fin de cet article, n’hésitez pas à les poser via les commentaires, car il est indispensable que vous ayez compris les enjeux pour que vous preniez le temps de mettre en place des 2 actions.

Une analyse de logs, c’est quoi ?

Une analyse de logs sert à analyser les visites des robots de Google dans le but de comprendre ce que font les robots de Google sur votre site pour identifier des axes d’amélioration pour votre site.

Ou peut-on trouver ces logs ?

Pour faire simple, votre serveur contient un fichier access.log qui recense toutes les informations enregistrées par le serveur sur lequel est hébergé votre site internet.

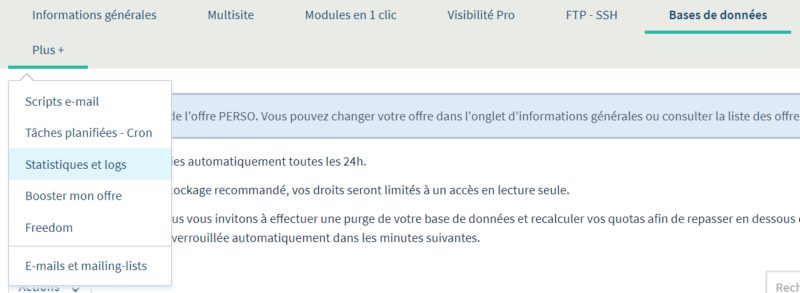

Ainsi, pour avoir accès à ce fichier, il vous suffit de vous rendre votre interface d’hébergement et de demander les logs d’access du site que vous avez envie d’analyser.

Par exemple, si votre site est hébergé sur OVH, il vous suffit d’aller dans votre espace client > Plus + > Statistiques et logs pour les télécharger les logs sur la période qui vous intéressent.

Que trouve-t-on dans des logs ?

Concrètement, ce fichier conserve un historique de tous les fichiers qui ont été consultés par les internautes et robots sur votre site. Parmi les informations conservées, on compte

- l’IP du visiteur

- les URLs consultés par le visiteur

- la date et l’heure de la consultation

- Le code et statut de la réponse http (200, 404, 500… etc)

- Le nombre d’octets renvoyés par le serveur

- La source de l’URL

Comment isoler les infos de Google ?

Comme je vous l’indiquais plus haut, ce fichier conserve les informations de toutes les venues de votre site, que cela soit des internautes, des robots ou autre.

Pour isoler les allers et venues des robots de Google, il va falloir retraiter vos données pour isoler toutes les entrées sur votre site dont l’IP commence par 66.249.

En effet, les robots de Google ont toujours une IP qui commence de la sorte, c’est la marque de fabrique de ces robots et ce qui permet d’analyser leurs comportements.

Quel est l’intérêt d’une analyse de logs ?

En analysant ces informations, il est possible d’identifier ce que voient les robots de Google lorsqu’ils visitent votre site:

- Combien d’URLs crawlent-ils par jour ?

- Quelles sont les URLs les plus crawlées ?

- Quelle est la part de visites sur chaque gabarit de votre site (Pages catégories, fiches produits…)

- Quelles sont les pages qui renvoient le plus d’octets et donc qui sont les plus lourdes

- Est-ce qu’ils rencontrent des URLs en erreur… etc.

- Est-ce qu’ils crawlent des pages qui ne devraient pas être crawlées

Toutes ces informations peuvent vous permettre d’identifier les axes d’améliorations techniques pour votre site.

Par exemple, vous pouvez vous rendre compte que Google passe 80% de son temps à crawler vos fiches produits au détriment des pages catégories. Pour réduire la part de crawl des fiches produits et augmenter les visites sur les pages catégories, votre axe d’amélioration sera alors d’améliorer votre maillage interne pour inciter les robots à aller voir plus régulièrement vos pages catégories, souvent positionnées sur des requêtes à fort volume de recherches…

Vous pouvez également vous rendre compte que Google crawle des éléments qu’il ne devrait pas crawler et qui affectent le budget de crawl de votre site… Par exemple des pages telles que des pages cachées ou qui devraient être bloquées (un espace privé par exemple)… Dans ce cas, il pourra être intéressant d’envisager de mettre en disallow ces pages dans votre robot.txt afin d’empêcher Google d’aller les voir.

Comment est-ce que cela peut améliorer votre référencement naturel ?

Vous l’aurez compris, une analyse de logs permet d’identifier les chemins préférentiels des robots de Google sur votre site.

En nettoyant ou en optimisant ces différents chemins, vous allez guider Google vers les pages les plus importantes de votre site et lui permettre d’accorder son attention sur celles-ci. Et si elles sont bien optimisées, vous allez ainsi améliorer le positionnement de ces pages dans les résultats du moteur de recherches américain.

Vous voyez l’idée ? Si oui, alors vous savez ce qu’il vous reste à faire ! N’hésitez plus et lancez-vous vite dans cette analyse, un peu technique mais foncièrement intéressante pour l’optimisation du SEO de votre site.